Intelligence artificielle : comment préparer les élèves à un monde où elle sera généralisée ?

Entretien croisé

Soraj Hongladarom est professeur de philosophie et directeur du centre d’éthique de la science et de la technologie à l’université Chulalongkorn de Bangkok. Il a publié de nombreux livres et articles sur des sujets aussi variés que la bioéthique, l’éthique des ordinateurs et les rôles de la science et de la technologie dans la culture des pays développés. Sa réflexion se concentre sur la manière dont l science et la technologie peuvent être intégrées dans la vie des populations des pays dits du Tiers-Monde, et sur les considérations éthiques qui en découlent. Il co-dirige la revue Information Technology Ethics: Cultural Perspectives, publiée par IGI Global.

Christophe Habas est neuro-radiologue, docteur en sciences Cognitives et ancien Grand Maître du Grand Orient de France.

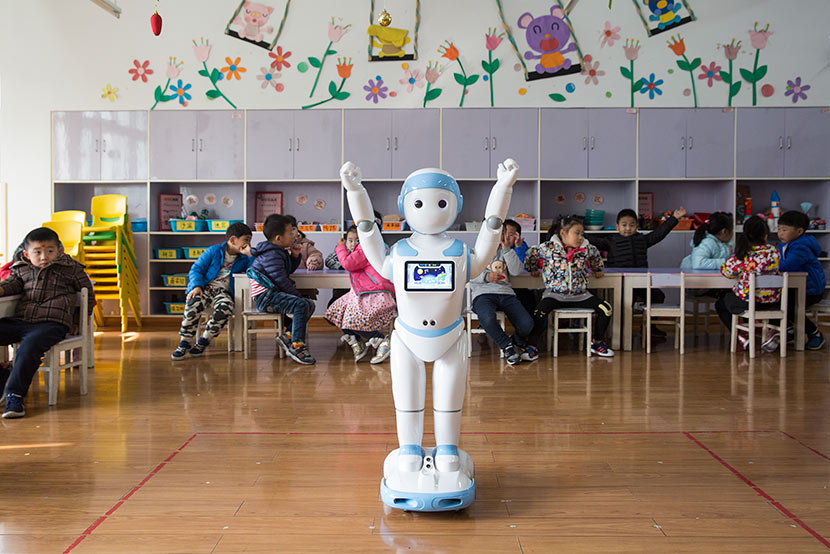

La Chine est donc un cas très intéressant de déploiement de l’IA dans une société et il faudra y porter attention dans les mois et les années qui viennent. Cela dit, il faut éduquer les jeunes générations à se sentir à l’aise avec les nouvelles technologies et l’IA car sinon, si elles sont vues comme incompréhensibles, étrangères ou dangereuses, ce sera une catastrophe. Cela ne veut pas dire qu’il faut tout accepter de la part de ceux qui poussent au développement de l’IA. Par exemple, en Thaïlande où la population est beaucoup plus critique par rapport au gouvernement qu’en Chine, il faut d’abord faire en sorte que les individus fassent confiance à l’IA. Et la seule manière d’y parvenir est que chacun soit assuré que cette technologie ne viendra pas heurter son propre système de valeurs.

Soutenez-nous !

Asialyst est conçu par une équipe composée à 100 % de bénévoles et grâce à un réseau de contributeurs en Asie ou ailleurs, journalistes, experts, universitaires, consultants ou anciens diplomates... Notre seul but : partager la connaissance de l'Asie au plus large public.

Faire un don